这次是在 NVIDIA 的一场技术面试中,候选人遇到了一道与 TensorRT 推理流程相关的工程题。题目背景直接设定在实际业务场景中,要求候选人基于给定描述完成一个可运行的原型实现。

面试官给出的英文原始描述如下:

You are an engineer on the TensorRT team tasked with developing algorithms for inference on neural networks.

A customer has provided a list of networks they are using for inference, and most of them involve a tensor reformat operation.

The reformat operation involves taking in a tensor containing floating-point numbers and outputting a similarly shaped tensor with low-precision integers.

You start off with a proof of concept for this functionality in a C++ program.

Task

Reformat tensor with given scale factor.

Create a function that takes in an FP32 tensor and a floating point scale factor as input.

Output an Int8 tensor by converting values using division by the given scale factor.

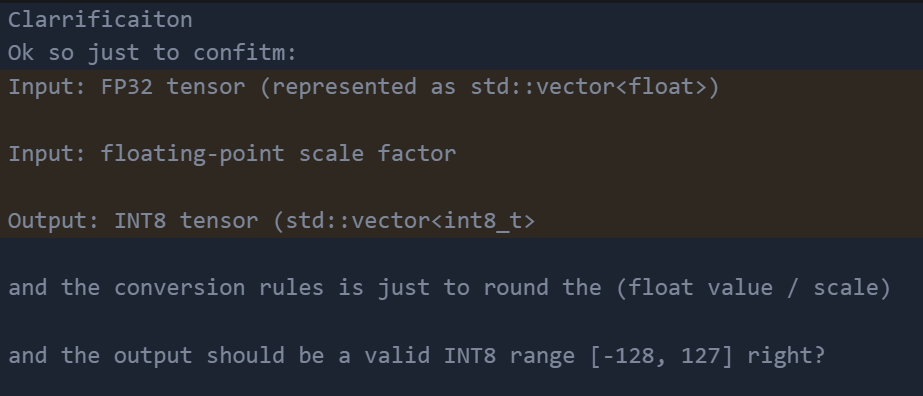

当题目出现之后,csoahelp面试辅助老师立即介入,开始写Clarrificaiton。随即候选人照着我们写的提示稿子念。逐句与面试官确认边界

我们在现场先协助候选人把输入输出的形态说清楚:张量 shape 不变,只对数值进行转换,scale factor 是一个浮点数,用于数值缩放。

在规则明确后,候选人开始依据我们的辅助文稿描述具体实现思路,包括如何遍历张量元素、如何进行浮点除法、以及结果如何映射到 Int8 类型。

整体很直接:遍历 FP32 tensor,每个值先除以 scale,再取整,最后保证结果落在 [-128, 127] 里。面试官这一段基本没打断,主要在听他能不能把步骤按顺序说清楚。

Algorihtm

I think basically we can just use a loop

For each element in the FP32 tensor

Divide the value by the scale factor.

Round the result to the nearest integer.

Clamp the value so it fits into the INT8 range

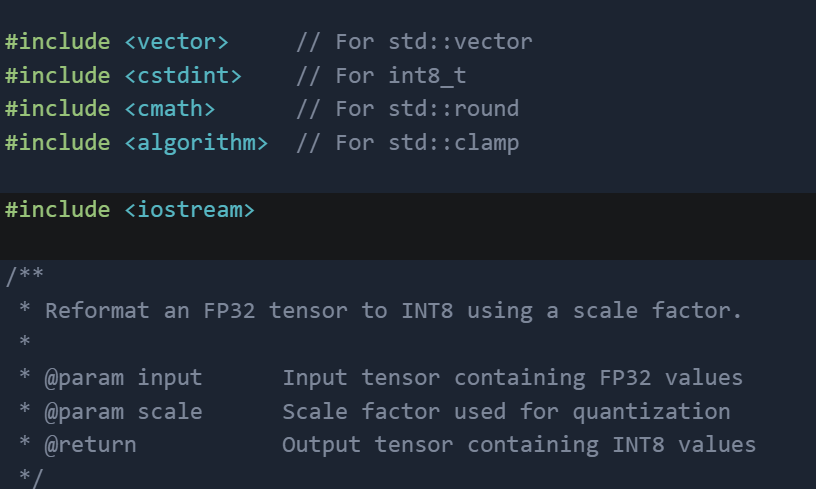

随后开始编码环节,csoahelp面试辅助能够在你面试的同时让辅助老师快速写出完整供候选人抄写

抄写完代码之后面试官开始进行各种追问。

我们在这里的辅助点也很明确,就是盯住“数值处理顺序”。先缩放、再 rounding、最后 clamp。顺序说清楚,后面被追问的时候就不会卡在“这一步到底什么时候做的”。

基础流程讲完后,面试官很快把话题转到 scale 本身,问 scale 是怎么来的,是不是每次都外部给。

候选人在这里顿了一下,我们就引导他从最直观的方案说起:用输入 tensor 的最大绝对值来算 scale。候选人随后解释了 max-abs calibration 的思路,把最大值映射到 INT8 的上限,避免溢出。

接着面试官追问代价。候选人顺着往下讲:如果 tensor 里有极端 outlier,scale 会被拉得很大,结果是大部分正常值量化后挤在很小的区间里,INT8 的动态范围用不满,精度会掉。

在这个基础上,他补充了两种工程里常见的处理方式:一种是 percentile-based calibration,比如用 90% 或 99% 分位点算 scale,少量超出的值直接 saturate 到 127 / -128;另一种是在量化前对输入做裁剪或预处理,避免明显异常值进入量化流程。

候选人全程围绕 TensorRT 的实际推理场景展开,逻辑保持一致,没有跑偏。

如果你也在准备英伟达或者其他科技大厂的面试,也想要辅助老师随时帮你解决面试问题,不妨联系我们,预约我们的面试辅助服务。

我们也有代面试,面试辅助,OA代写等服务助您早日上岸~